前提・実現したいこと

現在、以下のコードを参考にしてデータセットを置き換えて学習を行っています。

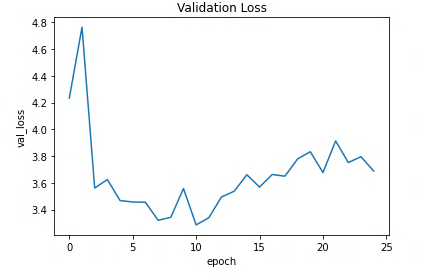

trainingはうまく進んでいるように見えますが、validationはうまくいっていません。元コードとの変更点はデータセットの変更を通すために少し変更した程度です。

いろいろ調べましたが、似たような例は見つからず困っている次第です。

よろしくお願いします。

使用しているデータセットは2048*4096,training:10400枚,validation:373枚です。(training dataは水増ししています。)

追記:とりあえず学習を進めてみているので何かあったら報告します。

・ReduceLP0nPlateauを追加して学習した結果、Epoch3以降val lossが上昇

・学習率を下げて学習した結果、地道にlossが下がるもののlossが4ほどで停滞する

回答1件

あなたの回答

tips

プレビュー