4つの説明変数による、一つの目的変数をシンプルなニューラルネットワークによって回帰モデルを生成しようとしています。

Datasetは、Combined Cycle Power Plant Data Set

https://archive.ics.uci.edu/ml/datasets/combined+cycle+power+plant

10000 datapoint

を利用し、試しています。

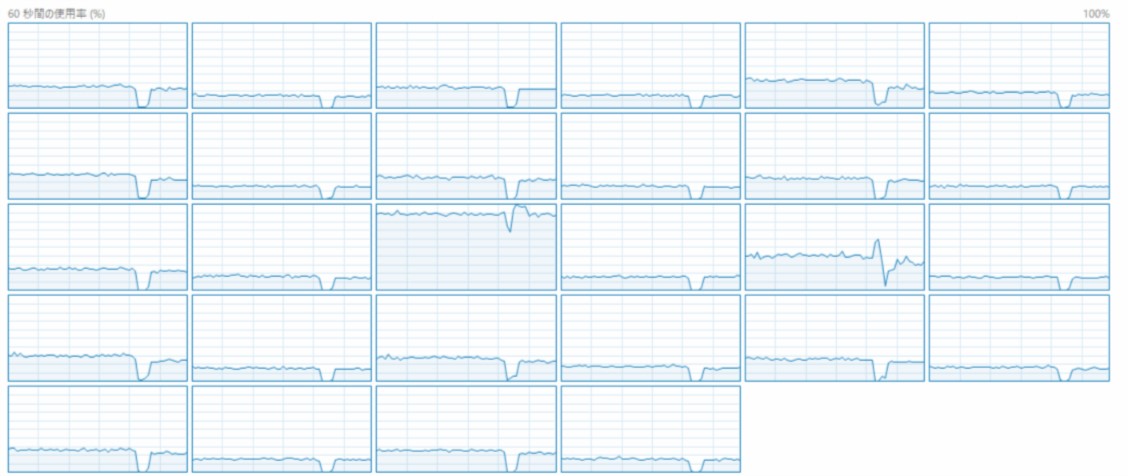

tensor-gpuを使用していますが、CPUとGPUの使用度が20-30パーセント程度で推移し、

CPUは14コアが平均的に使用されています。

このような回帰問題において、多くのコアを持つCPUやGPUを高速化に生かすことは、難しいのでしょうか?

Python

1Keras: net model 2model = Sequential() 3model.add(Dense(64, input_dim=input_features, activation='relu')) 4model.add(BatchNormalization()) 5model.add(Dense(128, activation='relu')) 6model.add(BatchNormalization()) 7model.add(Dense(128, activation='relu')) 8model.add(BatchNormalization()) 9model.add(Dense(128, activation='relu')) 10model.add(BatchNormalization()) 11model.add(Dense(128, activation='relu')) 12model.add(BatchNormalization()) 13model.add(Dense(64, input_dim=input_features, activation='relu')) 14model.add(BatchNormalization()) 15model.add(Dense(1, activation='linear')) 16model.compile(loss='mae', optimizer='adam') 17

EDIT1:Hardware info

CPU:i9-9940X

GPU:NVIDIA GeForce RTX2080

Memory:32 GB

OS:Windows