前提

機械学習の勉強中の者です。

データセットを自前で用意し、マッティングのモデルを構築し、実装しました。

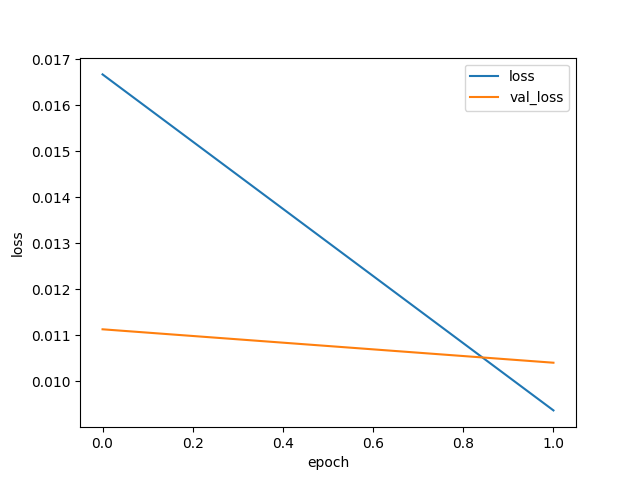

しかし、データセットの傾向が偏っていることもあり、少ないエポック数で十分にロスが下がります。

普通損失関数のグラフといえば、曲線で緩やかに収束していくと思うのですが、epoch数が1の場合直線で急激なロスの低下になってしまいます。(一応、train_lossの方がval_lossよりも低い値になっています。)

そこで、このようなグラフが出力された場合は、もう少しバッチサイズやエポック数を見直した方が良いのか、それともこの場合はこれで良しとして良いのかどうかが分かりません。

実現したいこと

モデルの学習をここで終了するべきかの判断をしたい。

該当のソースコード

python

1ソースコード

バッドをするには、ログインかつ

こちらの条件を満たす必要があります。

退会済みユーザー

2022/11/17 09:25

2022/11/17 09:44 編集