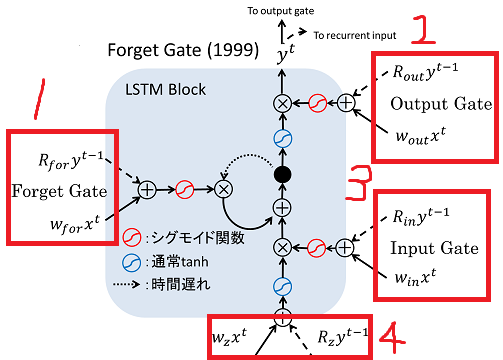

LSTMの定義のコードで重みwとバイアスbの定義方法がなぜそうなるか分かりません。

重みはなぜ入力層と隠れ層を足すのか分かりません

要するに3・4行目の数式がなぜそうなるかわからないとのことです。

教えてください

python

1 2n_input = 32 3n_hidden = 64 4w =np.random.randn(n_inputs+n_hidden,n_hidden*4) 5b = np.zeros(n_hidden*4) 6 7def lstm(x, h, c): 8 z = ...i = ...f = ...o = ...

参考書にこのような記載しかされておらずどなたか力を貸してください!

回答2件

あなたの回答

tips

プレビュー

2019/08/14 11:42