先日、Beautiful Soupを使用したスクレイピングについて伺ったものです。

その後、時系列でデータをスクレイピングし、CSVファイルに出力したいと思っているのですが、改行に悩まされています。

前提・実現したいこと

外務省のホームページから、経済関係に関する文言のみを時系列で取り出すために、以下のプログラムを書きました。

python

1import requests 2import re 3from bs4 import BeautifulSoup 4import csv 5import time 6import pandas as pd 7 8date = '1228104', '1257898', '1286149', '1364311', '1368305', '1368468', '1368659', '1368915', '1436746', '1621199', '1621978', '1712311', '1713002', '1886784', '1918820' 9i = 0 10 11honbun1 = list() 12 13for aa in date : 14 url = "http://warp.ndl.go.jp/info:ndljp/pid/" + date[i] + "/www.mofa.go.jp/mofaj/area/korea/data.html" 15 res = requests.get(url) 16 print(url) 17 time.sleep(10) 18 h4 = exa.find("h4", text=re.compile("経済関係")) 19 for m in h4.find_next_siblings("p", limit = 3): 20 honbun1.append(m.string) 21 i = i + 1 22 print(str(i) + "件目") 23 24 25df = pd.DataFrame(honbun1) 26df.to_csv(r"パス名", index=False, header=False, sep="\t") 27

発生している問題・エラーメッセージ

その後、PandasのDataframeを使用し、リストを時系列に作成したいのですが、このまま出力すると、find_next_siblingsでlimit=3としているせいなのか、文字列が改行されてしまいます。

いずれは他のデータとマージして、時系列で扱いたいと思っているので、同じ日付の記述は同じ行に追加したいのですが、方法がわからず質問させていただきました。

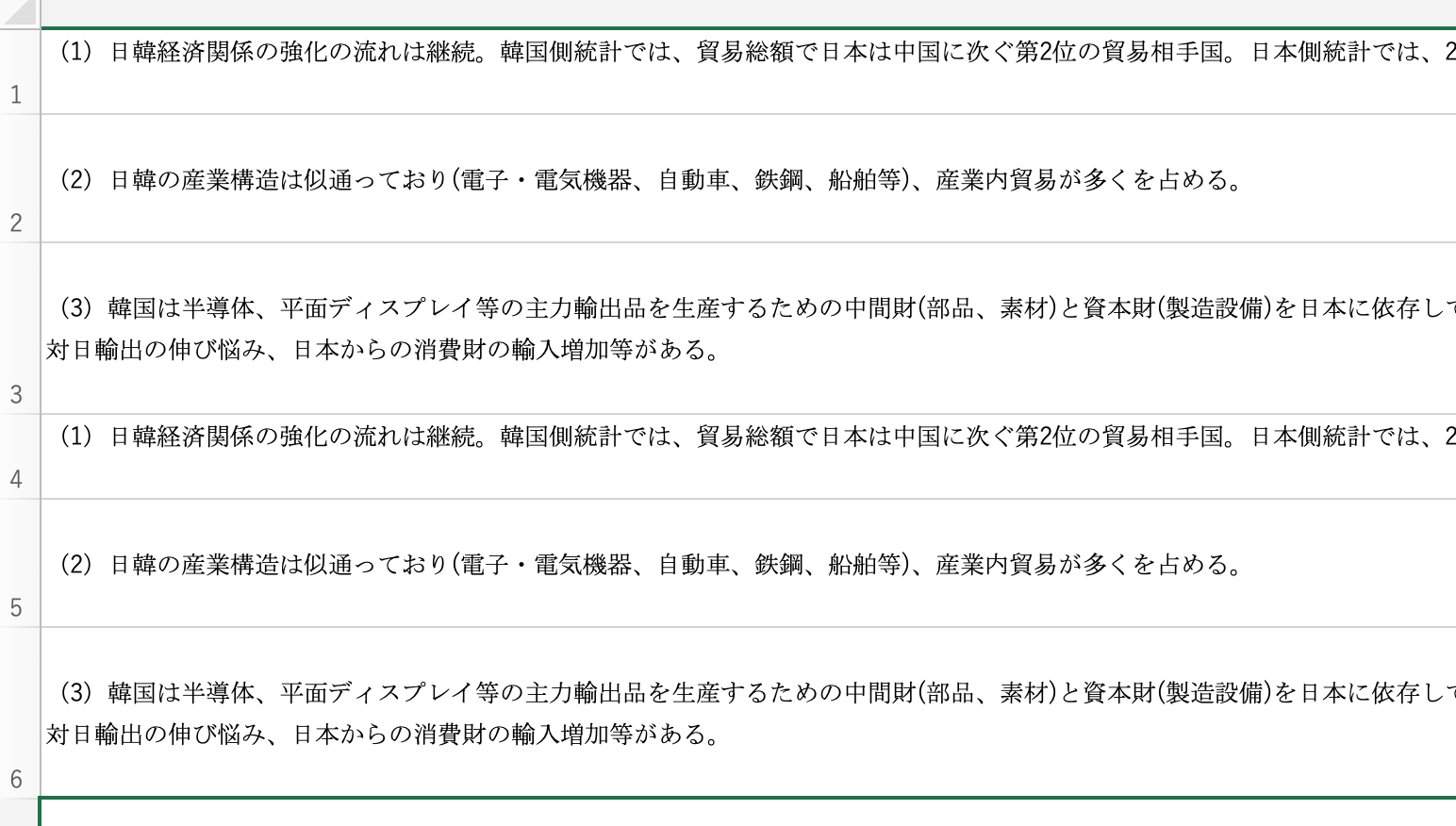

↓上記のコードを実行し、出力したCSVファイルです。改行がページごとでなく、本文の行ごとになってしまいます。

試したこと

以下のコードで要素を一度strオブジェクトに変換し、limit=2だけ取り出して結合する処理を行いました。

このhonbun_csv1というリストをDataFrameに変換したところ、同じ日付のものをまとめることはできました。

python

1 2honbunstr1 = list(map(str, honbun1)) 3 4 5honbun_csv1 = list() 6i = 0 7 8for n in honbunstr1 : 9 two = ''.join(honbunstr1[i:i+3]) 10 honbun_csv.append(three) 11 i = i + 3 12 13honbun_csv1 = list(filter(lambda a: a != "", honbun_csv1))

しかし、このウェブサイトは途中で記述方法や段落が変わることが少なくなく、このまま対応し続けると連続でうまく対応することができません。

h4 = exa.find("h4", text=re.compile("経済関係")) for m in h4.find_next_siblings("p", limit = 2): honbun1.append(m.string) i = i + 1 print(str(i) + "件目")

個人的にはスクレイパーのこの部分を変更し、1要素にまとめる必要があるのかなと思っているのですが…

大変わかりづらい説明、そして初歩的な質問申し訳ありません。

ご不明点ございましたら、追記させていただきますので、お力添え願えないでしょうか。

どうぞ宜しくお願い致します。

回答2件

あなたの回答

tips

プレビュー

バッドをするには、ログインかつ

こちらの条件を満たす必要があります。

2019/10/15 02:37