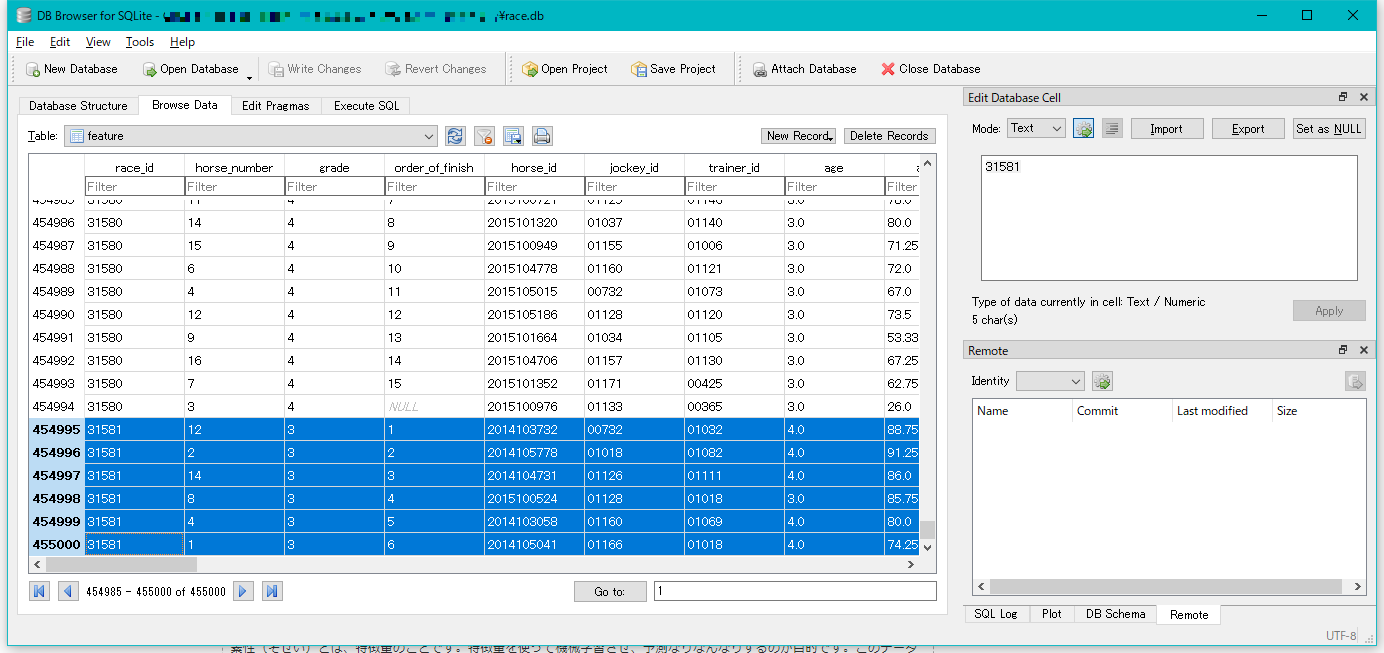

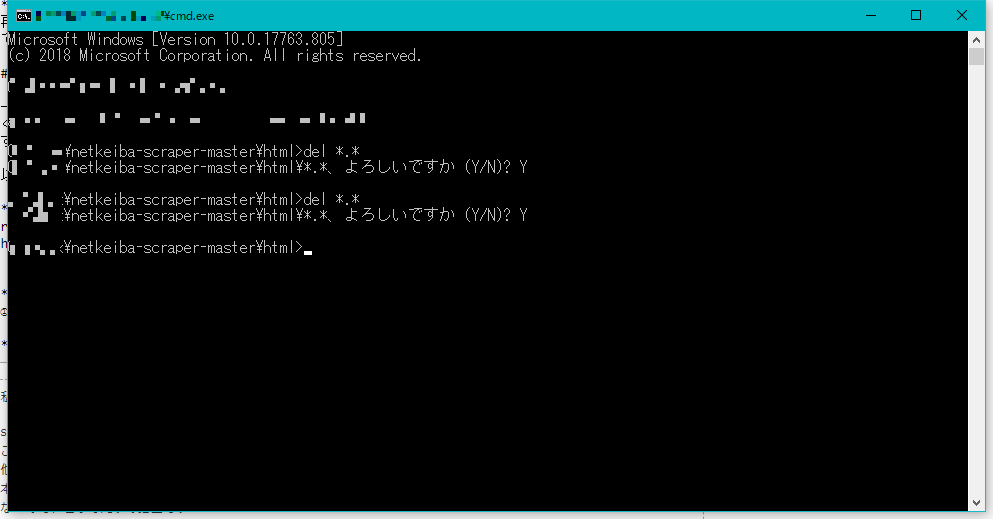

コード ```### 前提・実現したいこと scala初心者でございます。 stockedge/netkeiba-scraperで競馬情報をスクレイピングしておりますが、終盤の動作の途中で、以下のエラーメッセージが発生しました。 ### 発生している問題・エラーメッセージ [error] (run-main-0) java.lang.RuntimeException: class not found:サラ系3歳以上1勝クラス[指](定量) [error] java.lang.RuntimeException: class not found:サラ系3歳以上1勝クラス[指](定量) [error] at scala.sys.package$.error(package.scala:26) [error] at Util$.str2cls(Main.scala:1855) [error] at FeatureGenerator.$anonfun$gradeChanged$1(Main.scala:1521) [error] at scala.runtime.java8.JFunction1$mcII$sp.apply(JFunction1$mcII$sp.java:12) [error] at scala.Option.map(Option.scala:146) [error] at FeatureGenerator.<init>(Main.scala:1519) [error] at FeatureGenerator$.$anonfun$iterator$2(Main.scala:662) [error] at scala.collection.Iterator$$anon$10.next(Iterator.scala:455) [error] at scala.collection.Iterator$GroupedIterator.takeDestructively(Iterator.scala:1155) [error] at scala.collection.Iterator$GroupedIterator.go(Iterator.scala:1170) [error] at scala.collection.Iterator$GroupedIterator.fill(Iterator.scala:1207) [error] at scala.collection.Iterator$GroupedIterator.hasNext(Iterator.scala:1211) [error] at scala.collection.Iterator.foreach(Iterator.scala:937) [error] at scala.collection.Iterator.foreach$(Iterator.scala:937) [error] at scala.collection.AbstractIterator.foreach(Iterator.scala:1425) [error] at FeatureDao$.$anonfun$rr2f$1(Main.scala:1740) [error] at FeatureDao$.$anonfun$rr2f$1$adapted(Main.scala:1737) [error] at scalikejdbc.DBConnection.readOnly(DBConnection.scala:202) [error] at scalikejdbc.DBConnection.readOnly$(DBConnection.scala:200) [error] at scalikejdbc.DB.readOnly(DB.scala:60) [error] at scalikejdbc.DB$.$anonfun$readOnly$1(DB.scala:175) [error] at scalikejdbc.LoanPattern.using(LoanPattern.scala:18) [error] at scalikejdbc.LoanPattern.using$(LoanPattern.scala:16) [error] at scalikejdbc.DB$.using(DB.scala:140) [error] at scalikejdbc.DB$.readOnly(DB.scala:174) [error] at FeatureDao$.rr2f(Main.scala:1737) [error] at Main$.main(Main.scala:1995) [error] at Main.main(Main.scala) [error] at sun.reflect.NativeMethodAccessorImpl.invoke0(Native Method) [error] at sun.reflect.NativeMethodAccessorImpl.invoke(NativeMethodAccessorImpl.java:62) [error] at sun.reflect.DelegatingMethodAccessorImpl.invoke(DelegatingMethodAccessorImpl.java:43) [error] at java.lang.reflect.Method.invoke(Method.java:498) [error] Nonzero exit code: 1 [error] (Compile / run) Nonzero exit code: 1 [error] Total time: 5435 s, completed 2019/08/28 2:51:53 ### 該当のソースコード [info] Loading project definition from /Users/AAA/Desktop/netkeiba-scraper-master/project [info] Loading settings for project netkeiba-scraper-master from build.sbt ... [info] Set current project to netkeiba-scraper-master (in build file:/Users/AAA/Desktop/netkeiba-scraper-master/) [info] Running Main genfeature 01:21:20.287 [run-main-0] DEBUG scalikejdbc.ConnectionPool$ - Registered connection pool : ConnectionPool(url:jdbc:sqlite:race.db, user:null) using factory : <default> 01:21:20.291 [run-main-0] DEBUG scalikejdbc.ConnectionPool$ - Registered singleton connection pool : ConnectionPool(url:jdbc:sqlite:race.db, user:null) ### 試したこと 当たり前のことではございますが、stockedge/netkeiba-scraperの使い方の通りに最初からコマンドを実行してみました。 (以下マニュアル引用) 以下のコマンドを上から順に実行していけば最後に素性が作成される。 ①sbt "run collecturl" レース結果が載っているURLを収集して「race_list.txt」に保存する。 ②sbt "run scrapehtml" レース結果のHTMLをスクレイピングしてhtmlフォルダに保存する。HTMLをまるごとスクレイピングするので結構時間がかかる。 ③sbt "run extract" HTMLからレース結果を抜き出しSQLiteに保存する。 ④sbt "run genfeature" レース結果を元にして素性を作りSQLiteに保存する。 この④のコマンドを実行後に上記のエラーが発生いたしました。

投稿2019/08/28 14:43

バッドをするには、ログインかつ

こちらの条件を満たす必要があります。