機械学習で例えば回帰を行うとします。

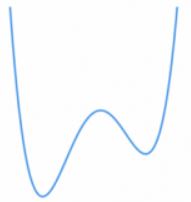

回帰曲線が非線形の場合では勾配法を用いますが、勾配法で局所解が生じる場合の回帰曲線の形が知りたいです。

回帰ではなく分類をする際の決定境界のモデルを決めるときの勾配法での局所解のできる形もできれば知りたいですが

話が複雑そうになるのでまず回帰から行きたいと思います。

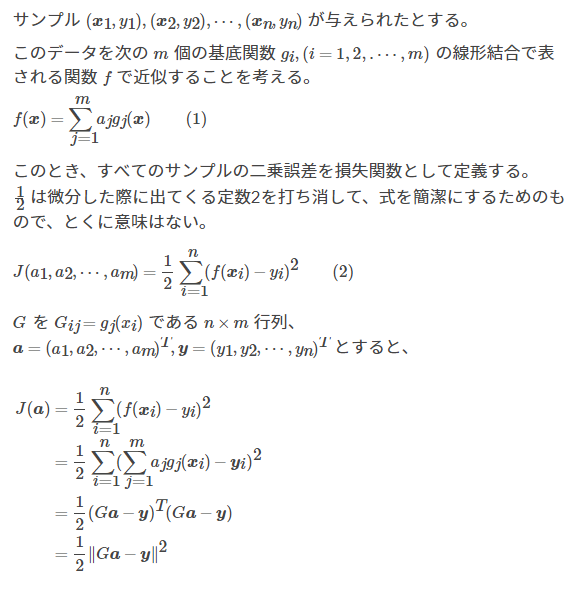

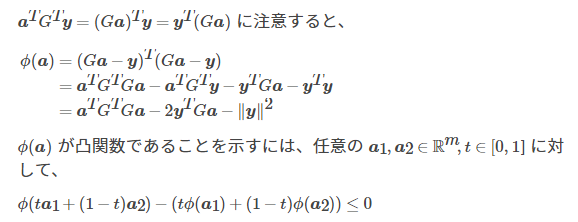

まず回帰曲線を

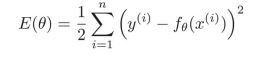

とし目的関数Eを

とします。

ここで勾配法の更新式は

ここで多項式回帰をするとし回帰曲線を

とします。多項式回帰の更新式は

となりますが

多項式回帰では図では次数が3次です。なので局所解は発生しませんが

次数が4次の場合の回帰曲線について

となるので次数が4次のパラメータで目的関数Eを微分すると勾配法の解が局所解に陥ってしまう

この際確率的勾配法が有効なのかなと思いました。

あってますか?

>回帰曲線が非線形の場合では勾配法を用いますが

とありますが、回帰曲線が次数2の多項式なら普通の(非線形ではない)最小二乗法を使い、正規方程式を解く方法でフィッティングできるのでは?

確かに次数2であれば線形であるので解析的に解くことができると思います。

勾配法を用いる必要性はないですね。今調べてみたところ3次4次でも解の公式があるらしく

次数4までは解析で解けるので勾配法を用いる必要はないんですかね?

ここで私が知りたいのは勾配法を使うと仮定して

真のパラメータθ1θ2θ3・・・等を求める際どのような時に局所解ができるのかということです。

回帰曲線を3次関数の次数3のパラメータで微分する際、勾配が真の解に向いてくれないということであっていますか?なので更新式で用いる一番最初のパラメータを決める場合、次数3であれば最低でも二回はパラメータを決めなおす必要があるということでしょうか

別に回帰曲線が10次でも100次でも、パラメータで偏微分して連立一元方程式になれば行列で解けます。なので、もう少し複雑な問題を持ってこないと議論しづらい気がします。

回答2件

あなたの回答

tips

プレビュー